- Análisis›

- Amazon EMR›

- Características

Características de Amazon EMR

Facilidad de uso

Información general

Amazon EMR simplifica la creación y la operación de entornos y aplicaciones de macrodatos. Las características relacionadas con EMR incluyen un aprovisionamiento fácil, escalado gestionado, reconfiguración de clústeres y EMR Studio para el desarrollo colaborativo.

Aprovisionar clústeres en minutos

Puede lanzar un clúster de EMR en cuestión de minutos. No hay que preocuparse por el aprovisionamiento de infraestructura, la disposición del clúster, la configuración ni el ajuste. EMR se encarga de estas tareas, lo que permite centrar a sus equipos en desarrollar aplicaciones de big data diferenciadas.

Escale recursos con facilidad para satisfacer las necesidades empresariales

Puede establecer fácilmente el escalado horizontal y el desescalado horizontal mediante las políticas de escalado administradas de EMR y dejar que su clúster EMR administre automáticamente los recursos de computación para satisfacer sus necesidades de uso y rendimiento. De esta manera, se mejora la utilización de los clústeres y se ahorra en costes.

EMR Studio

Es un entorno de desarrollo integrado (IDE) que facilita a los científicos e ingenieros de datos el desarrollo, la visualización y la corrección de aplicaciones de ingeniería y de ciencia de datos escritas en R, Python, Scala y PySpark. EMR Studio proporciona Jupyter Notebooks completamente administrado y herramientas como Spark UI y YARN Timeline Service para simplificar la depuración.

Alta disponibilidad con un solo clic

Puede configurar fácilmente la alta disponibilidad de aplicaciones multi-master como YARN, HDFS, Apache Spark, Apache HBase y Apache Hive con un solo clic. Cuando se habilita la compatibilidad con multi-master en EMR, EMR configurará estas aplicaciones para alta disponibilidad y, en caso de errores, automáticamente se llevará a cabo una conmutación por error a un nodo principal en espera para que su clúster no se interrumpa y ubicará sus nodos principales en distintos estantes para reducir el riesgo de falla simultánea. Los anfitriones se supervisan para detectar errores. Cuando se detectan problemas, los nuevos anfitriones se aprovisionan y añaden al clúster automáticamente.

Escalado administrado de EMR

Redimensiona el clúster de forma automática para obtener un mejor rendimiento al menor costo posible. Con el escalado administrado por EMR puede especificar los límites informáticos máximos y mínimos para sus clústeres y Amazon EMR los redimensiona automáticamente para el mejor rendimiento y uso de recursos. El escalado administrado por EMR prueba continuamente métricas clave asociadas con las cargas de trabajo que se ejecutan en clústeres.

Reconfigure con facilidad los clústeres en ejecución

Ahora puede modificar la configuración de las aplicaciones ejecutadas en clústeres de EMR como Apache Hadoop, Apache Spark, Apache Hive, y Hue, entre otras, sin reiniciar el clúster. La reconfiguración de aplicaciones de EMR le permitirá modificar aplicaciones sobre la marcha sin tener que apagar ni recrear el clúster. Amazon EMR aplicará las nuevas configuraciones y reiniciará la aplicación reconfigurada con facilidad. Las configuraciones se pueden aplicar a través de la consola, el SDK o la CLI.

Elasticidad

Información general

Amazon EMR le permite aprovisionar con rapidez y facilidad toda la capacidad que necesite, y agregarla o eliminarla de forma automática o manual. Es muy útil si cuenta con requisitos de procesamiento impredecibles o variables. Por ejemplo, si la mayor parte del procesamiento se produce por la noche, es posible que necesite 100 instancias durante el día y 500 por la noche. También puede suceder que necesite una gran capacidad durante un breve período de tiempo. Con Amazon EMR, puede aprovisionar rápidamente cientos o miles de instancias, escalar automáticamente para satisfacer los requisitos de capacidad informática y eliminar el clúster cuando se complete el trabajo (para evitar pagar por una capacidad inactiva).

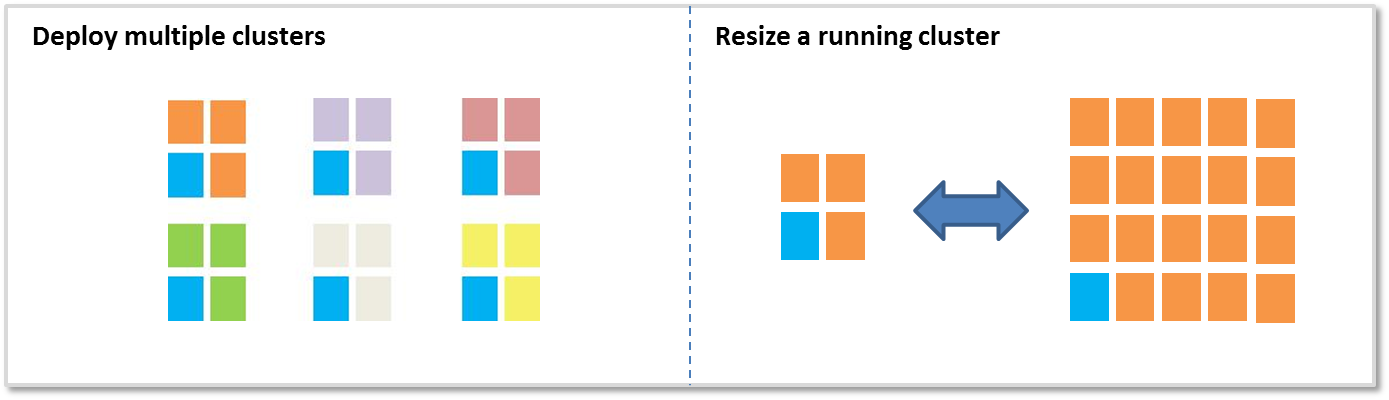

Existen dos opciones principales para agregar o eliminar capacidad:

Desplegar varios clústeres

Si necesita más capacidad, puede lanzar con facilidad un nuevo clúster y finalizarlo cuando ya no lo necesite. No existe ningún límite en cuanto al número de clústeres que puede tener. Es posible que quiera utilizar varios clústeres si tiene varios usuarios o aplicaciones. Por ejemplo, puede almacenar los datos de entrada en Amazon S3 y lanzar un clúster por cada aplicación que necesite procesar los datos. Se puede optimizar un clúster para la CPU, otro para el almacenamiento, etc.

Redimensionar un clúster en ejecución

Con Amazon EMR, es fácil usar Escalado administrado por EMR, escalar automáticamente o redimensionar manualmente un clúster en ejecución. Quizás desee ampliar un clúster para añadir más potencia de procesamiento de forma temporal o reducir el clúster para ahorrar costes cuando tenga capacidad inactiva. Por ejemplo, algunos clientes agregan cientos de instancias a sus clústeres cuando se produce el procesamiento por lotes y eliminan las instancias adicionales cuando se completa el procesamiento. Al agregar instancias al clúster, EMR puede empezar a utilizar la capacidad aprovisionada en cuanto esté disponible. Cuando reduzca la escala, EMR elegirá de manera proactiva nodos inactivos para reducir el impacto en las tareas en ejecución.

Bajo costo

Información general

Amazon EMR está diseñado para reducir el costo de procesamiento de grandes volúmenes de datos. Algunas de las características que permiten que tenga un costo reducido son los precios por segundo, la integración con las instancias de subasta de Amazon EC2, la integración con las instancias reservadas de Amazon EC2, la elasticidad y la integración con Amazon S3.

Precios bajos por segundo

Los precios de Amazon EMR se aplican por segundo con un mínimo de un minuto y comienzan con 0,015 USD por hora de instancia en el caso de las instancias pequeñas (131,40 USD al año). Para obtener más información, consulte la sección de precios.

Integración de spot de Amazon EC2

El precio de las instancias de spot de Amazon EC2 varía en función de la oferta y la demanda de las instancias, pero nunca deberá pagar más que el precio máximo que haya especificado. Amazon EMR facilita el uso de instancias de spot para que pueda ahorrar tiempo y dinero. Los clústeres de Amazon EMR incluyen “nodos principales” que ejecutan HDFS y “nodos de tarea” que no lo hacen. Los nodos de tarea son perfectos para las instancias de spot porque, si el precio de spot aumenta y pierde esas instancias, no perderá los datos almacenados en HDFS. (Más información sobre los nodos principales y de tarea). Con la combinación de flotas de instancias, las estrategias de asignación para instancias de spot, Escalado administrado por EMR y más opciones de diversificación, puede optimizar EMR para resistencia y costo. Si desea obtener más información, lea nuestro blog.

Integración con Amazon S3

El sistema de archivos de EMR (EMRFS) permite que los clústeres de EMR utilicen Amazon S3 como almacén de objetos para Hadoop de manera segura y eficaz. Puede almacenar sus datos en Amazon S3 y utilizar varios clústeres de Amazon EMR para procesar el mismo conjunto de datos. Es posible optimizar cada clúster para una carga de trabajo en especial, lo que puede ser más eficiente que disponer de un solo clúster para varias cargas de trabajo con requisitos diferentes. Por ejemplo, podría tener un clúster optimizado para la E/S y otro para la CPU y que cada uno procese el mismo conjunto de datos en Amazon S3. Además, al almacenar los datos de entrada y de salida en Amazon S3, puede cerrar clústeres cuando no sean necesarios.

EMRFS ofrece un nivel de rendimiento alto en operaciones de lectura y escritura en Amazon S3, admite el cifrado en el servidor S3 o en el cliente S3 mediante AWS Key Management Service (KMS) o con claves administradas por el cliente. Además, incluye una vista unificada opcional que comprueba la coherencia de lista y lectura tras escritura de objetos cuyo seguimiento se realiza en los metadatos. Además, los clústeres ERM de Amazon son compatibles tanto con EMRFS como con HDFS, lo que elimina la necesidad de elegir entre el almacenamiento en clústeres y Amazon S3.

Integración con el catálogo de datos de AWS Glue

Puede usar el catálogo de datos de AWS Glue como repositorio de metadatos administrado para almacenar metadatos de tablas externas para Apache Spark y Apache Hive. Además, ofrece la detección de esquemas automática y un historial de las versiones de los esquemas. Eso le permite continuar enviando metadatos con facilidad a sus tablas externas en Amazon S3 fuera de su clúster.

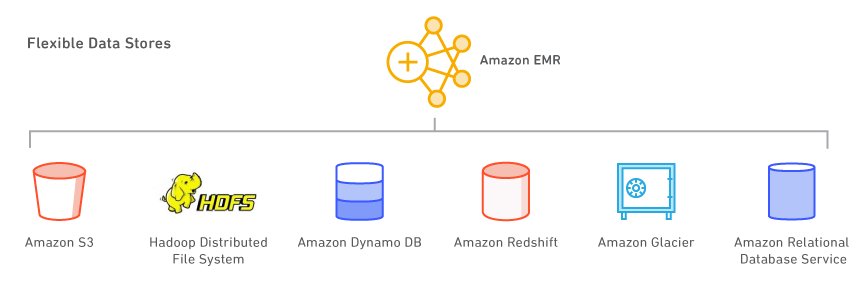

Almacenes de datos flexibles

Información general

Con Amazon EMR puede aprovechar varios almacenes de datos, incluidos Amazon S3, Hadoop Distributed File System (HDFS) y Amazon DynamoDB.

Amazon S3

Amazon S3 es un servicio de almacenamiento de larga duración, escalable, seguro, ágil y económico. Gracias al sistema de archivos de EMR (EMRFS), Amazon EMR puede utilizar Amazon S3 como almacén de objetos para Hadoop de manera segura y eficaz. Amazon EMR ha realizado numerosas mejoras en Hadoop para que pueda procesar grandes cantidades de datos almacenados en Amazon S3 sin problemas. Además, EMRFS permite utilizar una vista unificada para comprobar la coherencia de lista y lectura tras escritura de los objetos incluidos en Amazon S3. EMRFS admite cifrado en el servidor S3 o en el cliente S3 para procesar objetos cifrados de Amazon S3, y puede usar AWS Key Management Service (KMS) o un proveedor de claves personalizadas.

Al lanzar el clúster, Amazon EMR transfiere los datos desde Amazon S3 a cada instancia del clúster y empieza a procesarlos inmediatamente. Una ventaja del almacenamiento de los datos en Amazon S3 y su procesado con Amazon EMR es que puede utilizar varios clústeres para procesar los mismos datos. Por ejemplo, podría disponer de un clúster de desarrollo de Hive optimizado para la memoria y un clúster de producción de Pig optimizado para la CPU que utilicen el mismo conjunto de datos de entrada.

Sistema de archivos distribuidos de Hadoop (HDFS)

HDFS es el sistema de archivos de Hadoop. La topología actual de Amazon EMR agrupa sus instancias en tres grupos lógicos: el grupo Master, que ejecuta YARN Resource Manager y el servicio HDFS Name Node; el grupo Core, que ejecuta el daemon HDFS DataNode y el servicio YARN Node Manager; y el grupo Task, que ejecuta el servicio YARN Node Manager. Amazon EMR instala HDFS en el almacenamiento asociado con las instancias del grupo Core.

Cada instancia EC2 incluye un volumen fijo de almacenamiento denominado "almacén de instancias" que está adjunto a la instancia. También puede personalizar el almacenamiento de una instancia mediante la incorporación de volúmenes de Amazon EBS. Amazon EMR permite agregar los tipos de volumen General (SSD), Aprovisionado (SSD) y Magnético. Los volúmenes de EBS que se agregan a un clúster de EMR no persisten si este se apaga. EMR limpia automáticamente los volúmenes una vez termina el clúster.

También puede habilitar el cifrado completo para HDFS con una configuración de seguridad de Amazon EMR o crear manualmente zonas de cifrado HDFS con el servidor de administración de claves de Hadoop. Puede usar una configuración de seguridad para cifrar un dispositivo raíz EBS y almacenar volúmenes cuando especifique AWS KMS como su proveedor clave. Para obtener más información, consulte Cifrado de disco local.

Amazon DynamoDB

Amazon DynamoDB es un servicio de bases de datos NoSQL completamente administrado. Amazon EMR cuenta con una integración directa con Amazon DynamoDB para que pueda procesar datos almacenados en Amazon DynamoDB de forma rápida y eficiente, y transferir datos entre Amazon DynamoDB, Amazon S3 y HDFS en Amazon EMR.

Otros almacenes de datos de AWS

También puede usar Amazon Relational Database Service (un servicio web que facilita la configuración, el funcionamiento y el escalado de bases de datos relacionales en la nube), Amazon Glacier (un servicio de almacenamiento con un costo extremadamente bajo que ofrece un almacenamiento seguro y duradero para el respaldo y el archivado de datos) y Amazon Redshift (un servicio de almacén de datos con escalado de petabytes, rápido y completamente administrado). AWS Data Pipeline es un servicio web que lo ayuda a procesar datos y a transferirlos de manera confiable entre diferentes servicios de almacenamiento e informática de AWS (como Amazon EMR), así como entre orígenes de datos locales en intervalos especificados.

Use sus aplicaciones de código abierto favoritas

Información general

Mediante los lanzamientos con control de versiones en Amazon EMR, puede seleccionar y usar fácilmente los últimos proyectos de código abierto en su clúster de EMR, incluidas las aplicaciones presentes en los ecosistemas Apache Hadoop y Spark. El software lo instala y configura Amazon EMR, para que pueda dedicar más tiempo a aumentar el valor de sus datos sin preocuparse por tareas administrativas y de infraestructura.

Herramientas de big data

Información general

Amazon EMR es compatible con herramientas eficientes y probadas de Hadoop, como Apache Spark, Apache Hive, Presto y Apache HBase. Los científicos de datos utilizan EMR para ejecutar herramientas de aprendizaje profundo y aprendizaje automático como TensorFlow, Apache MXNet y, mediante procesos de arranque, añaden herramientas y bibliotecas específicas de casos de uso. Los analistas de datos utilizan EMR Studio, Hue y EMR Notebooks para el desarrollo interactivo y para crear trabajos de Apache Spark y enviar consultas de SQL a Apache Hive y Presto. Los ingenieros de datos utilizan EMR para el desarrollo de la canalización y el procesamiento de datos, y utilizan Apache Hudi para simplificar la administración de datos de crecimiento gradual y los casos de uso de privacidad de datos que requieren operaciones de inserción, actualización y eliminación de nivel de registro.

Procesamiento de datos y aprendizaje automático

Apache Spark es un motor en el ecosistema de Hadoop destinado al procesamiento rápido de conjuntos de datos de gran tamaño. Utiliza conjuntos de datos distribuidos resistentes (RDD), tolerantes a errores y en la memoria y gráficos acíclicos dirigidos (DAG) para definir las transformaciones de los datos. Spark también incluye Spark SQL, Spark Streaming, MLlib y GraphX. Conozca qué es Spark y obtenga más información sobre Spark en Amazon EMR.

Apache Flink es un motor de flujo de datos de streaming que facilita la ejecución del procesamiento de transmisiones en tiempo real en orígenes de datos de alto rendimiento. Admite la semántica de hora de evento para eventos fuera de servicio, semántica de exactamente una vez, control de contrapresión y API optimizadas para escribir tanto aplicaciones de streaming como por lotes. Descubra qué es Flink y obtenga más información sobre Flink en EMR.

TensorFlow es una biblioteca de matemática simbólica de código abierto para aplicaciones de inteligencia automática y aprendizaje profundo. TensorFlow agrupa varios algoritmos y modelos de aprendizaje automático y aprendizaje profundo, y puede entrenar y ejecutar redes neuronales profundas para muchos casos de uso diferentes. Obtenga más información sobre TensorFlow en EMR.

Administración de datos de nivel de registro de Amazon S3

Apache Hudi es un marco de administración de datos de código abierto que se utiliza para simplificar el procesamiento de datos incrementales y el desarrollo de canalizaciones de datos. Apache Hudi le permite administrar datos a nivel de registro en Amazon S3 para simplificar la captura de datos de cambio (CDC) y la incorporación de datos de transmisión, y proporciona un marco para manejar casos de uso de privacidad de datos que requieren actualizaciones y eliminaciones de nivel de registro. Obtenga más información sobre Apache Hudi en Amazon EMR.

SQL

Apache Hive es un almacén de datos y un paquete de análisis de código abierto que se ejecuta sobre Hadoop. Hive funciona gracias a Hive QL, un lenguaje basado en SQL que permite que los usuarios estructuren, resuman y consulten datos. Hive QL es más que el SQL estándar, ya que incluye un soporte excelente con funciones map y reduce y tipos de datos complejos y ampliables que define el usuario, como JSON y Thrift. Esta capacidad permite procesar orígenes de datos complejos y desestructuradas, como documentos de texto y archivos de registro. Hive admite las extensiones de usuario a través de funciones definidas por el usuario escritas en Java. Amazon EMR ha efectuado numerosas mejoras en Hive, incluida la integración directa con Amazon DynamoDB y Amazon S3. Por ejemplo, con Amazon EMR puede cargar particiones de tabla automáticamente desde Amazon S3, puede escribir datos en tablas de Amazon S3 sin usar archivos temporales y puede obtener acceso a recursos de Amazon S3, como secuencias de datos para operaciones map y reduce personalizadas y bibliotecas adicionales. Descubra qué es Hive y obtenga más información acerca de Hive en EMR.

Presto es un motor de consultas SQL distribuido de código abierto optimizado para el análisis de datos ad hoc de baja latencia. Es compatible con el estándar ANSI SQL, incluidas las consultas complejas, las agregaciones, las uniones y las funciones de ventana. Presto puede procesar datos procedentes de diversos orígenes de datos, incluidos Hadoop Distributed File System (HDFS) y Amazon S3. Descubra qué es Presto y obtenga más información acerca de Presto en EMR.

Apache Phoenix brinda capacidades de transacciones SQL con ACID de baja latencia con datos almacenados en Apache HBase. Puede crear índices secundarios con facilidad para incrementar el rendimiento y crear vistas distintas de la misma tabla HBase subyacente. Obtenga más información acerca de Phoenix en EMR.

NoSQL

Apache HBase es una base de datos distribuida, no relacional y de código abierto inspirada en BigTable, de Google. Se desarrolló como parte del proyecto Hadoop de Apache Software Foundation y se ejecuta sobre Hadoop Distributed File System (HDFS) para ofrecer capacidades estilo BigTable para Hadoop. HBase ofrece una manera eficiente y a prueba de errores para almacenar grandes volúmenes de datos dispersos con almacenamiento y compresión basados en columnas. Además, HBase proporciona una búsqueda rápida de datos, ya que almacena en caché datos en memoria. HBase se optimizó para las operaciones de escritura secuencial y es muy eficiente para las eliminaciones, actualizaciones e inserciones por lotes. HBase trabaja sin problemas con Hadoop al compartir su sistema de archivos y servir como entrada y salida directa para los trabajos de Hadoop. HBase también se integra con Apache Hive, lo que permite las consultas de tipo SQL en tablas de HBase, las uniones con tablas basadas en Hive y el soporte para Java Database Connectivity (JDBC). Con EMR, puede usar S3 como almacén de datos para HBase, lo que le permite reducir los costos y la complejidad operativa. Si utiliza HDFS como almacén de datos, puede crear copias de seguridad de HBase en S3 y hacer restauraciones a partir de una copia se seguridad creada con anterioridad. Descubra qué es HBase y obtenga más información acerca de HBase en EMR.

Análisis interactivo

EMR Studio es un entorno de desarrollo integrado (IDE) que facilita a los científicos e ingenieros de datos el desarrollo, la visualización y la corrección de aplicaciones de ingeniería y de ciencia de datos escritas en R, Python, Scala y PySpark. EMR Studio proporciona Jupyter Notebooks completamente administrado y herramientas como Spark UI y YARN Timeline Service para simplificar la depuración.

Hue es una interfaz de usuario de código abierto para Hadoop que facilita la ejecución y el desarrollo de consultas de Hive, la administración de archivos en HDFS, la ejecución y el desarrollo de secuencias de comandos de Pig y la administración de tablas. Hue en EMR también se integra con Amazon S3, lo que permite realizar consultas directamente en S3 y transferir archivos fácilmente entre HDFS y Amazon S3. Obtenga más información acerca de HUE y EMR.

Cuaderno de Jupyter es una aplicación web de código abierto que se puede utilizar para crear y compartir documentos que contienen código, ecuaciones, visualizaciones y texto narrativo en directo. JupyterHub permite alojar múltiples instancias de un servidor de Jupyter Notebook de un solo usuario. Cuando crea un clúster de EMR con JupyterHub, EMR crea un contenedor de Docker en el nodo maestro del clúster. JupyterHub, todos los componentes necesarios para Jupyter y Sparkmagic se ejecutan en el contenedor.

Apache Zeppelin es una interfaz de usuario gráfica de código abierto que crea cuadernos interactivos y colaborativos para la exploración de datos mediante Spark. Puede usar Scala, Python, SQL (mediante Spark SQL) o HiveQL para manipular datos y visualizar rápidamente los resultados. Los cuadernos de Zeppelin se pueden compartir entre varios usuarios y las visualizaciones se pueden publicar en paneles externos. Obtenga más información acerca de Zeppellin en EMR.

Programación y flujo de trabajo

Apache Oozie es un programador de flujos de trabajo para Hadoop en el que puede crear gráficos acíclicos dirigidos (DAG) de acciones. También puede activar fácilmente sus flujos de trabajo Hadoop por acciones o por tiempo. Obtenga más información acerca de Oozie en EMR. AWS Step Functions le permite agregar una automatización de flujo de trabajo sin servidor a sus aplicaciones. Los pasos de su flujo de trabajo pueden ejecutarse en cualquier lugar, incluso en las funciones de AWS Lambda, en Amazon Elastic Compute Cloud (EC2) o en las instalaciones. Obtenga más información sobre Step Functions en EMR.

Otros proyectos y herramientas

EMR también admite una gran variedad de aplicaciones y herramientas conocidas, como R, Apache Pig (procesamiento de datos y ETL), Apache Tez (ejecución de DAG complejos), Apache MXNet (aprendizaje profundo), Ganglia (supervisión), Apache Sqoop (conector de bases de datos relacionales), HCatalog (administración de almacenamiento y tablas), entre otras. El equipo de Amazon EMR dispone de un almacén de código abierto de acciones de arranque que se puede utilizar para instalar software adicional, configurar su clúster o a modo de ejemplo para escribir sus propias acciones de arranque.

Control de acceso a los datos

Información general

De manera predeterminada, los procesos de aplicaciones de Amazon EMR utilizan el perfil de instancia EC2 cuando llaman a otros servicios de AWS. En el caso de clústeres de varios usuarios, Amazon EMR ofrece tres opciones para administrar el acceso de los usuarios a los datos de Amazon S3.

La integración con AWS Lake Formation le permite definir y administrar políticas de autorización detalladas en AWS Lake Formation para acceder a bases de datos, tablas y columnas en el Catálogo de datos de AWS Glue. Puede aplicar las políticas de autorización en trabajos enviados mediante Cuadernos de Amazon EMR y Apache Zeppelin para cargas de trabajo de EMR Spark interactivas, y enviar eventos de auditoría a AWS CloudTrail. Al habilitar esta integración, también habilita Single Sign-On federado para EMR Notebooks o Apache Zeppelin desde sistemas de identidad empresarial compatibles con Security Assertion Markup Language (SAML) 2.0.

La integración nativa con Apache Ranger le permite configurar un servidor nuevo o existente de Apache Ranger para definir y administrar políticas de autorización detalladas para el acceso de usuarios a bases de datos, tablas y columnas de datos de Amazon S3 mediante Hive Metastore. Apache Ranger es una herramienta de código abierto que permite habilitar, monitorear y administrar de forma pormenorizada la seguridad de los datos en la plataforma Hadoop.

Esta integración nativa le permite definir tres tipos de políticas de autorización en el servidor de administración de políticas de Apache Ranger. Puede definir autorizaciones a nivel de fila, de columna y de tabla para Hive, a nivel de columna y de tabla para Spark y, por último, a nivel de prefijo y de objeto para Amazon S3. Amazon EMR instala y configura de forma automática los complementos correspondientes de Apache Ranger en el clúster. Estos complementos de Ranger se sincronizan con el servidor de administración de políticas para determinar las autorizaciones, aplicar las políticas de acceso a datos y enviar los eventos de auditoría a Registros de Amazon CloudWatch.

El mapeador de roles de usuario de Amazon EMR le permite sacar partido de los permisos de AWS IAM para administrar el acceso a los recursos de AWS. Puede crear mapeos entre usuarios (o grupos) y roles de IAM personalizados. Un usuario o grupo solo puede acceder a los datos permitidos por el rol de IAM personalizado. En la actualidad, esta característica se encuentra disponible a través de los Laboratorios de AWS.

Experiencia híbrida consistente

Información general

AWS Outposts es un servicio completamente administrado que amplía la infraestructura de AWS, los servicios de AWS, las API y las herramientas a prácticamente cualquier centro de datos, espacio de coubicación o instalación local para lograr una experiencia híbrida estable. Amazon EMR en AWS Outposts le permite desplegar y administrar los clústeres EMR en su centro de datos utilizando la misma Consola de administración de AWS, el mismo kit de desarrollo de software (SDK) y la misma interfaz de la línea de comandos (CLI) utilizados para EMR.

Características adicionales

Seleccione la instancia adecuada para su clúster

Puede elegir qué tipos de instancias EC2 aprovisionar en su clúster (estándar, memoria alta, CPU alta, E/S alta, etc.) en función de los requisitos de su aplicación. Dispone de acceso raíz a todas las instancias y puede personalizar por completo el clúster para que se adapte a sus requisitos. Obtenga más información sobre los tipos de instancias Amazon EC2 admitidos. Amazon EMR ahora ofrece un costo hasta 30 % menor y hasta un 15 % de rendimiento mejorado para cargas de trabajo de Spark en instancias basadas en Graviton2. Obtenga más información en nuestro blog.

Control de acceso de red a su clúster

Puede lanzar el clúster en nube virtual privada (VPC) de Amazon, una sección aislada de forma lógica de la nube de AWS. Puede controlar todos los aspectos del entorno de red virtual, incluida la selección de su propio rango de direcciones IP, la creación de subredes y la configuración de tablas de ruteo y puertas de enlace de red. Obtenga más información sobre Amazon EMR y Amazon VPC.

Depuración de aplicaciones

Cuando habilita la depuración en un clúster, Amazon EMR archiva los archivos de registro en Amazon S3 y luego los indexa. A continuación, puede usar una interfaz gráfica en la consola para buscar los registros y ver el historial de trabajos de una manera intuitiva. Obtenga más información sobre la depuración de trabajos de Amazon EMR.

Administración de los usuarios, los permisos y el cifrado

Puede utilizar las herramientas de AWS Identity and Access Management (IAM), como las funciones y los usuarios de IAM, para controlar el acceso y los permisos. Por ejemplo, puede otorgar permisos de lectura, pero no de escritura, a determinados usuarios en los clústeres. Además, puede utilizar las configuraciones de seguridad de Amazon EMR para definir diversas opciones de cifrado en reposo y en tránsito, incluido el cifrado de Amazon S3 y la autenticación con Kerberos. Obtenga más información sobre el control del acceso a su clúster y sobre las opciones de cifrado de Amazon EMR.

Monitorización del clúster

Puede utilizar Amazon CloudWatch para supervisar métricas personalizadas de Amazon EMR, como el número medio de tareas de asignación y reducción en ejecución. También puede establecer alarmas para estas métricas. Obtenga más información sobre la supervisión de clústeres de Amazon EMR.

Instalación de un software adicional

Puede utilizar acciones de arranque o una imagen de máquina de Amazon (AMI) personalizada con Amazon Linux para instalar software adicional en su clúster. Las acciones de arranque son secuencias de comandos que se ejecutan en los nodos del clúster cuando Amazon EMR lanza el clúster. Se ejecutan antes de que se inicie Hadoop y antes de que el nodo empiece a procesar datos. También puede cargar con anterioridad y utilizar software en una AMI con Amazon Linux personalizada. Obtenga más información acerca de las acciones de arranque de Amazon EMR y las AMI con Amazon Linux personalizadas.

Respuesta a los eventos

Puede usar los tipos de evento de Amazon EMR en Eventos de Amazon CloudWatch para responder a los cambios de estado en los clústeres de Amazon EMR. Mediante el uso de reglas sencillas puede definir configuraciones rápidamente, hacer coincidir eventos y redirigirlos a temas de Amazon SNS, funciones de AWS Lambda, colas de Amazon SQS y otros. Obtenga más información sobre los eventos en los clústeres de Amazon EMR.

Copiado eficiente de datos

Puede trasladar rápidamente grandes volúmenes de datos de Amazon S3 a HDFS, de HDFS a Amazon S3 y entre buckets de Amazon S3 con S3DistCp de Amazon EMR, una extensión de la herramienta de código abierto Distcp que usa MapReduce para llevar a cabo esta tarea de forma eficiente. Obtenga más información sobre S3DistCp.

Programación de flujos de trabajo recurrentes

Puede usar AWS Data Pipeline para programar flujos de trabajo recurrentes que involucren a Amazon EMR. AWS Data Pipeline es un servicio web diseñado para ayudarlo a procesar datos y a transferirlos, de manera fiable y a intervalos definidos, entre diferentes servicios de almacenamiento e informática de AWS, así como entre orígenes de datos en las instalaciones. Obtenga más información sobre EMR y AWS Data Pipeline.

JAR personalizado

Escriba un programa de Java, compílelo para la versión de Hadoop que quiera utilizar y cárguelo en Amazon S3. Luego podrá enviar trabajos de Hadoop al clúster con la interfaz de Hadoop JobClient. Obtenga más información sobre el procesado de JAR personalizado con Amazon EMR.

Aprendizaje profundo

Utilice marcos de aprendizaje profundo conocidos, como Apache MXNet, para definir, entrenar y desplegar redes neuronales profundas. Puede utilizar estos marcos en clústeres de Amazon EMR con instancias GPU. Obtenga más información sobre MXNet en Amazon EMR.